Explore with Torsten Reidt, AI Engineer of The Cactai Team, the fascinating world of artificial intelligence in this interesting article. Discover the pivotal moments that have shaped the field of AI and explore the significant role Generative AI plays in today’s technological landscape. Whether you’re an AI enthusiast or simply curious about the evolution of this transformative technology, this comprehensive overview offers valuable insights into the past, present, and future of AI.

In het huidige digitale tijdperk is het bijna onmogelijk om te ontsnappen aan de drukte rond kunstmatige intelligentie (AI). Een snelle zoektocht op internet levert dagelijks miljoenen nieuwe vermeldingen op. De ontwikkeling van deze technologie gaat in een adembenemend tempo. Voordat ik in de huidige stand van zaken duik, wil ik eigenlijk een stap terug doen en beginnen met een blik op de geschiedenis van AI.

About 70 years ago, in the year 1956 to be exact, Alan Turing’s paper “Computing Machinery and Intelligence” was published. Even though the term “Artificial Intelligence” was not mentioned explicitly, Turing raised interesting questions and thoughts. The term “Artificial Intelligence” itself was coined in 1956 in the Dartmouth Summer Research Project.

Al sindsdien wordt er actief onderzoek gedaan op het gebied van kunstmatige intelligentie. Het traject is echter niet lineair geweest. Golven van opwinding (meer onderzoeksgelden) werden gevolgd door zogenaamde “AI-winters” (minder onderzoeksgelden). De lijst van prestaties onderweg is vrij lang, daarom zal ik slechts enkele mijlpalen uitlichten zonder afbreuk te doen aan het belang van andere, niet genoemde prestaties.

Now that we have seen that the development had its ups and downs over the last 70 years, what led to the current AI boom? Why is everyone talking about this technology nowadays? I would argue, that breakthrough developments in a single sub-domain of AI is the reason for that: Generative AI.

Generatieve AI verwijst naar een type kunstmatige intelligentie dat algoritmen voor machinaal leren gebruikt om nieuwe inhoud te genereren, zoals afbeeldingen of tekst. Tijdens de trainingsfase analyseren deze algoritmen enorme datasets om patronen, structuren en kenmerken in de gegevens te identificeren. De geleerde structuren worden vervolgens gebruikt om nieuwe inhoud te creëren.

Hoewel de mogelijkheid om beelden te genereren met Generative Adversarial Networks misschien onder de radar van het grote publiek is gebleven, was de release van chatGPT door OpenAI behoorlijk ontwrichtend. Misschien heeft de mogelijkheid om natuurlijke taal te begrijpen en erop te reageren AI op een bepaalde manier vermenselijkt of misschien was het gewoon de eerste keer dat het grote publiek toegang had tot een AI-systeem via een gebruiksvriendelijke gebruikersinterface – wat het ook was, chatGPT heeft zeker de publieke perceptie van AI veranderd.

Als er tegenwoordig over AI wordt gesproken, denken mensen vaak aan systemen die tekst als invoer nemen (een vraag) en tekst als uitvoer geven (het antwoord). De modellen die dit soort toepassingen aandrijven, worden “Large Language Models” (LLM) genoemd. De eerder beschreven toepassing wordt ook wel “chatbot” genoemd. Andere taken waarin LLM’s schitteren zijn het samenvatten van tekst, tekstclassificatie of sentimentanalyse.

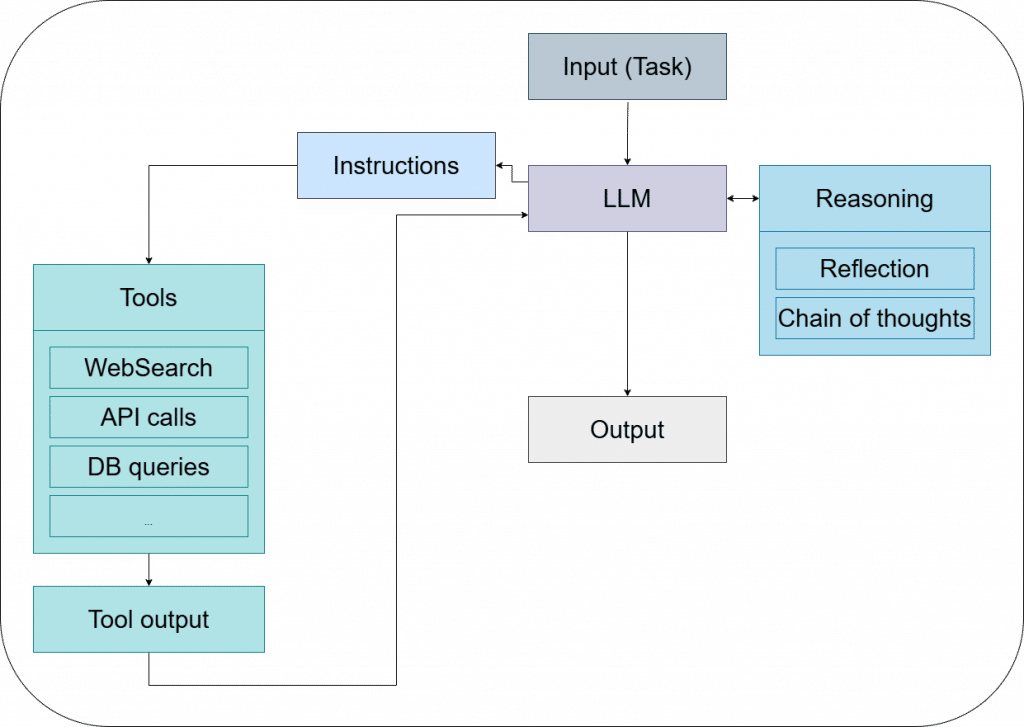

De meest interessante en recente toepassing voor LLM’s is naar mijn mening Agentic Systems. Een Agentic System bestaat uit één of meerdere agenten. Elke agent wordt aangedreven door een LLM die het systeem in staat stelt doelgericht te zijn, een zekere mate van autonomie te hebben en te kunnen redeneren en beslissingen te nemen. Hoewel LLM’s gebonden zijn aan tekstinvoer/uitvoer, integreert een agent vaak met externe tools, databases of API’s om zijn mogelijkheden uit te breiden tot meer dan tekstgeneratie. Een schema van een Agentic System (enkele agent) wordt getoond in de volgende figuur.

Je kunt het LLM in deze context zien als het brein van de agent. De rechterkant van de figuur beschrijft hoe het LLM moet handelen. Als de Agent een mens was, zou je dit ruwweg omschrijven als een “manier van denken”. De linkerkant van de figuur laat een aantal voorbeelden zien van Tools die de Agent kan gebruiken. Op dit punt is het belangrijk om te onthouden dat LLM’s alleen tekst als invoer kunnen nemen en alleen tekst als uitvoer kunnen creëren. Daarom maakt de LLM instructies over welk gereedschap met welke functieargumenten moet worden gebruikt. De functieaanroep zelf gebeurt programmatisch met een module van een derde partij. De resultaten van de functieaanroep (indien aanwezig) worden dan teruggestuurd naar de LLM en verder verwerkt. Wat betreft de Tools zelf: de verbeelding bepaalt de grenzen. Wat ik daarmee bedoel is dat je elke functionaliteit kunt implementeren die je nodig hebt. Dit kan een API-aanroep zijn, een database query of zelfs een interactie met je besturingssysteem.

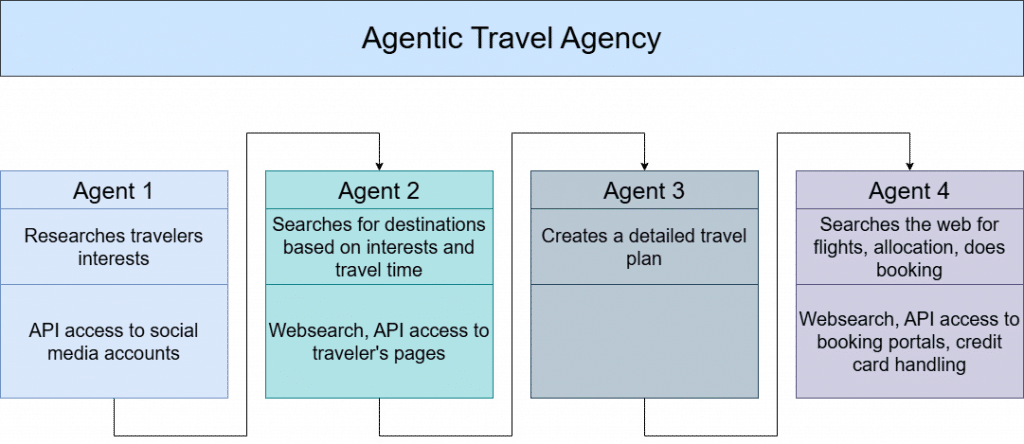

Om een voorbeeld te geven van waar een Agentic System gebruikt kan worden om processen te automatiseren, stel ik me een Agentic Travel Agency voor. Ik gebruik een systeem van verschillende agenten die de taak van het plannen en boeken van een vakantiereis opeenvolgend afhandelen. De volgende figuur laat zien hoe dit systeem eruit zou kunnen zien.

Hoewel het bovenstaande voorbeeld zou kunnen suggereren dat het opzetten van een Agentic System een eenvoudige taak is, wil ik benadrukken dat dit niet noodzakelijkerwijs het geval is. Voor een betrouwbaar Agentic System in een productieomgeving krijg je te maken met de niet-deterministische aard van LLM’s, veranderende invoerprompts of zelfs veranderingen in LLM-versies, om maar een paar uitdagingen te noemen.

As I mentioned earlier, natural language-based systems usually come into mind when discussing AI. However, there are many other interesting areas within Artificial Intelligence such as Speech Recognition, Music Generation or Computer Vision. For the latter, I would like to highlight the subdomain Object Detection.

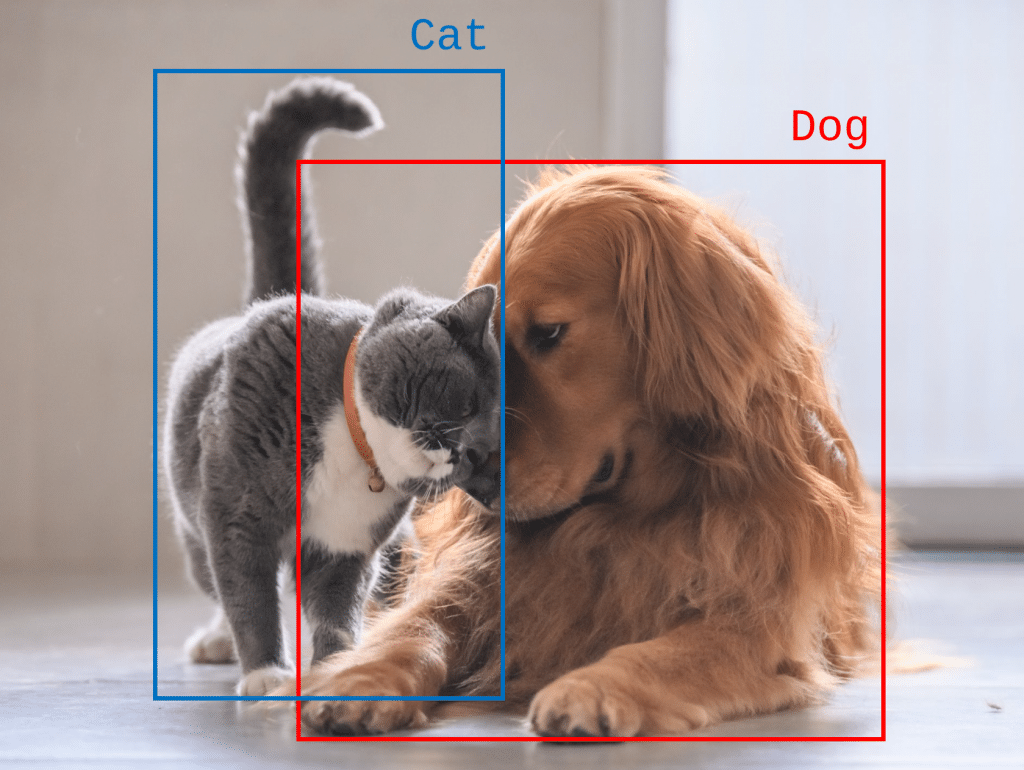

Objectdetectie bestaat al een tijdje, maar heeft aan belang gewonnen door zijn toepassing in sectoren zoals medische beeldvorming, bewakingssystemen of zelfrijdende auto’s. De primaire taken bij objectdetectie zijn het lokaliseren en classificeren van objecten in afbeeldingen of video. De belangrijkste taken bij Objectdetectie zijn het lokaliseren en classificeren van objecten in afbeeldingen of video. De volgende afbeeldingen illustreren typische resultaten van Objectdetectie waarbij twee objecten zijn gelokaliseerd (gemarkeerd met een bounding box) en geclassificeerd (gelabeld met tekst) in een enkele afbeelding. Toegepast op video’s maakt Objectdetectie het mogelijk om objecten van het ene frame naar het volgende frame te volgen.

Als je Objectdetectie wilt toepassen, hoef je meestal niet vanaf nul te beginnen, omdat er vooraf getrainde open-source modellen beschikbaar zijn, zoals YOLO (You Only Look Once), Faster R-CNN of RetinaNet, terwijl YOLO waarschijnlijk de populairste is.

Beide uitgelichte systemen, de Agentic Systems using Large Language Models en Object Detection using YOLO, zijn slechts twee inleidende voorbeelden van AI-toepassingen. Er zijn nog veel meer AI-systemen die ons dagelijks leven al beïnvloeden. Denk maar aan NETFLIX die je volgende film aanbeveelt, de SPAM-filter in je e-mailaccount of Google die advertenties afstemt op jouw voorkeuren. Deze indrukwekkende, maar gespecialiseerde mogelijkheden zouden ons na een tijdje nadenken kunnen leiden naar de oorspronkelijke vraag van deze blogpost:

Stijgen de machines?

I would argue that they are not, at least not yet. Current AI systems are designed and trained to perform well on very specific tasks such as text generation or Object Detection in images. This specialization limits their versatility in other domains. To overcome this situation, there is a significant development in combining individual capabilities into Multimodal Artificial Intelligence models. This new class of models can process different types of input such as images, video or text. Some examples are OpenAI’s GPT-4o (combines any combination of text, images or speech as input), kytai’s moshi (combines text and speech input), and LLaVA (combines image and text input).

De ontwikkeling van multimodale kunstmatige intelligentie wordt door velen gezien als een cruciale stap op weg naar kunstmatige algemene intelligentie (AGI), die de menselijke capaciteiten in een breed scala aan cognitieve taken moet evenaren of zelfs overtreffen.

Desondanks deze vooruitgang schieten alle huidige modellen, inclusief de Multimodale modellen, nog steeds tekort op verschillende belangrijke gebieden, waaronder:

- Human-like redeneren en problemen oplossen

- Generalisatie over domeinen heen

- Capability to adapt to new situations

- Echt leren en begrijpen

- Contextbegrip

- Bewustzijn en zelfbewustzijn

- Creativiteit en innovatie

Alleen door deze uitdagingen aan te gaan, kunnen we getuige zijn van een kunstmatig systeem dat in de buurt komt van menselijke intelligentie. Onderzoekers en grote technologiebedrijven zoals Microsoft, Google, Meta, OpenAI of Amazon zullen dit pad waarschijnlijk volgen. Zelfs als ze daar niet in slagen, zullen er veel nieuwe stappen zijn die we in toekomstige blogposts kunnen belichten.

Wat is de volgende stap?

Terwijl de machines nog niet in opkomst zijn, vordert de ontwikkeling van AI in hoog tempo. Agentic Systems in combinatie met multimodale modellen creëren mogelijkheden om processen te stroomlijnen, taken te automatiseren en nieuwe zakelijke kansen te genereren. Bij Cactus onderzoeken we al deze mogelijkheden, terwijl we kritieke kwesties zoals gegevensprivacy, ethiek en mogelijke vooroordelen in gedachten houden. Naarmate we verder gaan, zullen we deze ontwikkelingen blijven volgen en nieuwe mijlpalen delen in toekomstige blogberichten.